POR HELENA OLIVEIRA

Em Maio último, a Google colocou um anúncio que procurava pilotos de testes para a sua unidade de investigação em veículos autónomos. O mesmo foi considerado pelos bloggers da tecnologia como o verdadeiro emprego de sonho. Afinal, quem não gostaria de ganhar vinte dólares à hora para estar sentado num carro, sem fazer absolutamente nada, durante oito horas seguidas? O problema é que as reacções nos media sociais, em particular dos não adeptos da tecnologia, não foram as esperadas e colocaram mais uma acha na já ardente fogueira dos que temem a inteligência artificial, no geral e, neste caso em particular, no que já é vulgarmente denominado como “veículos autónomos” (VA). E o motivo fica suficientemente explícito num comentário ao dito anúncio feito no Facebook: “Teriam de me pagar muito mais para me conseguirem enfiar nessa lata que usa a sua própria mente”.

Este episódio consta da extensa matéria de capa publicada na mais recente edição da revista Fortune e dedicada à corrida, cada vez mais acelerada, dos automóveis do futuro – leia-se daqui a quatro ou cinco anos – os quais serão suficientemente autónomos para “conduzirem” sem qualquer tipo de intervenção humana. Todavia, e apesar de esta nova indústria estar a ser aguerridamente disputada não só pelos fabricantes gigantes e tradicionais do mercado, como a Volkswagen, a Mercedes ou a Ford, entre outros, mas também pelos incumbentes ambiciosos da tecnologia, como a Google, a Tesla, e até a Uber, a verdade é que existem inúmeras questões éticas que poderão travar, abrandar ou, se bem resolvidas, acelerar este novo e promissor sector.

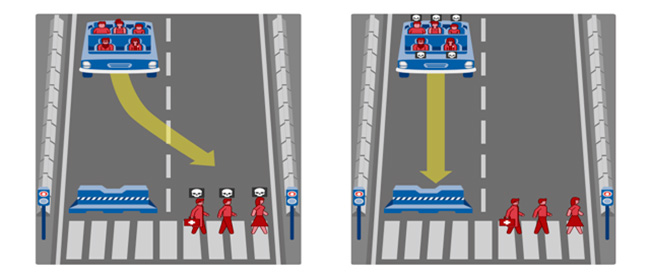

Imagine, para já, que é o proprietário de um destes veículos autónomos e que está a passear, sossegadamente, com a sua família num cenário bucólico e muito agradável à vista. Mas e de repente, surge na estrada uma bola saltitante imediatamente seguida por uma criança que a quer recuperar. Deverá o seu carro inteligente escolher a segurança da criança, guinando para a direita onde o espreita um precipício e colocando-o a si, e à sua família, em risco de morte ou, pelo contrário, deverá colocar a sua segurança, e a dos seus, em primeiro lugar, atropelando a criança?

Este cenário constitui apenas um, entre muitos, dos dilemas éticos e morais que a condução autónoma está a colocar não só aos fabricantes deste tipo de automóveis, mas também aos seus potenciais compradores e, é claro, aos reguladores. E foi tema de um estudo publicado a 24 de Junho último, na revista Science. A maioria dos quase dois mil americanos que fizeram parte do estudo em causa considerou que este tipo de veículos deveria ser programado para evitar, a todo o custo, magoar ou matar a criança (ou quem quer que corresse o mesmo risco), mesmo que tal significasse colocar em perigo os passageiros do veículo. De acordo com os investigadores responsáveis pelo estudo, Jean-François Bonnefon, da Toulouse School of Economics, em França, Azim Shariff, da University of Oregon e Iyad Rahwan, do Media Lab do MIT, citados pela revista Scientific American, “os algoritmos que controlam os veículos autónomos terão de incorporar princípios morais que orientem as suas decisões em situações de danos inevitáveis”.

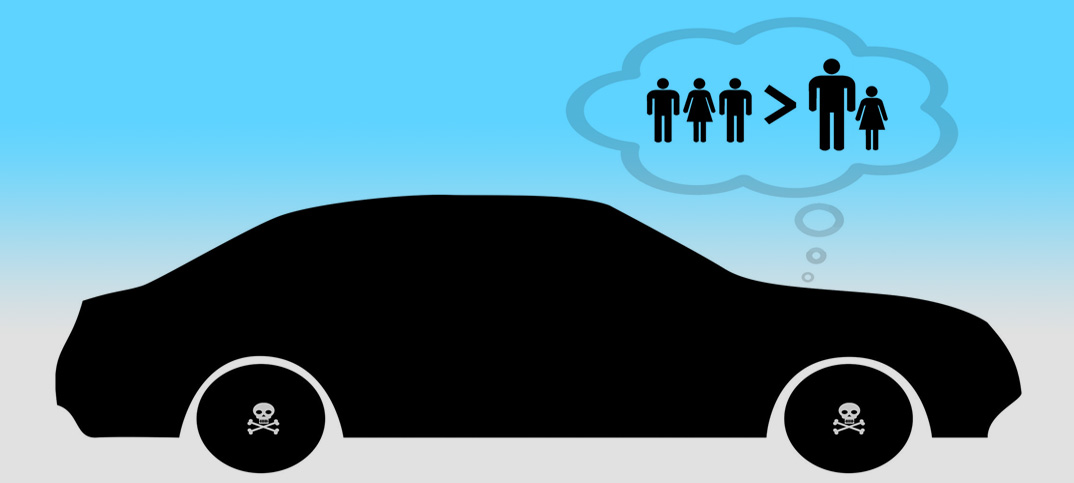

Se é verdade que a escolha moral mais óbvia, pelo menos em teoria, será a de privilegiar o bem maior em detrimento da própria segurança do condutor ou dos passageiros – o que gerou consenso nas várias experiências similares conduzidas pelos três investigadores – o caso muda “ligeiramente” de figura quando o que está em jogo e na prática, é a nossa própria vida, ou seja, essas mesmas pessoas que escolheram a opção moral certa, considerariam comprar antes um carro autónomo que, pelo contrário, “decidisse” salvar o condutor ou passageiros, mesmo que tal implicasse sacrificar a vida de outrem.

Ou, como é melhor explicado no website da motherboard: “em todos os inquéritos realizados, a maioria das pessoas considerou que seria mais moralmente aceite que um veículo autónomo sacrificasse o seu condutor para salvar mais pessoas [esta experiência consiste numa variação do famoso dilema ético do “eléctrico desgovernado”] e que estes carros deveriam ser programados para minimizar os danos de muitos, em vez de apenas alguns. E mesmo quando foi proposto imaginar que eram os próprios respondentes, ou alguém que lhes era querido, no lugar do condutor, a maioria continuou a concordar que esta seria a mais moral das decisões”.

Todavia, existe uma outra questão que contribui para aumentar o dilema em causa: quando questionados sobre quão interessados estariam em comprar um automóvel que os sacrificasse a eles ou às suas famílias ou um outro modelo que fosse “auto-protector” e que colocasse, sempre, as suas próprias vidas em primeiro lugar, essa mesma maioria optaria pela segunda hipótese. Ou, em suma, e porque somos humanamente egoístas e não queremos morrer, mesmo tendo consciência de qual a opção mais ética, os entrevistados optariam por salvar a sua própria pele.

Esta preferência, “humana q.b.”, contribuiu também para que os investigadores concluíssem que, quando chegar a altura dos legisladores se pronunciarem sobre a prioridade ética de se salvaguardar os peões em detrimento dos condutores – pois terá de existir uma regulação neste sentido – as pessoas terão muito menos vontade de adquirir este tipo de veículos inteligentes. Adicionalmente, afirma também o estudo, se tal acontecer, o mercado para os veículos autónomos poderá diminuir, o mesmo acontecendo com o desenvolvimento das tecnologias que os irão caracterizar e apesar de todas as pesquisas até agora realizadas apontarem para factos inegáveis: estes veículos irão reduzir significativamente o tráfego, serão substancialmente muito menos poluidores e salvarão, – porque são muito mais seguros – a vida de milhares de pessoas todos os anos. É que comprovado está também o facto de o erro humano contribuir para cerca de 90% de todos os acidentes automóveis. O que é o mesmo que afirmar que estamos perante um dilema ético ainda maior.

Quem decide: a ética ou os dados?

Como em tudo, existe sempre “o outro lado da questão” e são vários os observadores – o tema tem gerado uma discussão intensa por toda a Internet – que apresentam as “falhas” deste estudo. Um deles é o professor de Engenharia Eléctrica e Computacional, Raj Rajkumar, que dirige o Cylab na Universidade de Carneggie Mellon e considerado como um dos mais reconhecidos especialistas na pesquisa dos veículos autónomos, tendo sido, aliás, o vencedor do DARPA 2007 Urban Challenge, o concurso em que, pela primeira vez, os primeiros veículos autónomos interagiram, com e sem condutores, com um tráfego normal numa zona urbana.

Para este investigador, são dois os principais problemas que assombram as conclusões do estudo em causa: a primeira é que o mesmo não leva em linha de conta de que forma é que a inteligência artificial está a ser desenvolvida e como funciona verdadeiramente neste tipo de carros e, o segundo, é que a questão da ética está a transformar-se num tópico popular entre as pessoas que NÃO trabalham com a tecnologia. Se o primeiro argumento pode ser aceitável pelos comuns dos mortais, já o segundo é muito mais discutível. A inteligência artificial e a robótica estão a progredir muito mais rapidamente do que seria expectável e, quando dermos conta, o futuro já é presente e muitas questões éticas têm e terão, necessariamente, de ser discutidas sob pena de perdermos completamente o controlo das nossas vidas enquanto humanos.

Todavia, e sendo esta uma matéria interminável, atentemos somente aos argumentos de Raj Rajkumar.

Afirmando que a inteligência artificial não tem as mesmas capacidades cognitivas do que os humanos – o que parece uma verdade de La Palisse – Rajkumar acrescenta que as decisões tomadas pelos veículos autónomos têm como base, ao invés, critérios como a velocidade, as condições climatéricas, o estado das estradas, as distâncias e um conjunto amplo de outros dados reunidos através de uma variedade de sensores, incluindo câmaras, LIDARS [acrónimo para Light Detection and Ranging – ou seja, detecção e localização por laser] e radares.

Como explicou à Scientific American, um carro autónomo irá calcular a decisão mais adequada com base na velocidade a que está a circular e de acordo com a distância a que se encontra determinado obstáculo (carros ou pessoas) no seu caminho. Para o professor e investigador, o desafio principal nestas circunstâncias reside na recolha e processamento dos dados necessários, com a rapidez suficiente para evitar, antes de mais, qualquer circunstância perigosa. Apesar de reconhecer que esta “prevenção atempada” não será sempre possível, é absolutamente céptico no que respeita aos casos em que o veículo deverá decidir quem vive e quem morre. E, alerta, “a minha maior preocupação relativa aos veículos autónomos está relacionada com a capacidade de os manter protegidos de hackers que possam assumir o seu controlo com alguém a bordo”.

Rajkumar não está sozinho no outro dilema que se nos apresenta: o facto de 90% dos acidentes serem causados pelos próprios humanos e de as tecnologias poderem ajudar, e muito, a diminuir esta, muitas vezes, mortal percentagem.

Como todos sabemos, cada vez que ligamos o nosso carro e seguimos o nosso caminho, somos constantemente obrigados a tomar, igualmente, decisões éticas e morais que têm impacto não só na nossa segurança, como na dos outros: conduzir a uma velocidade superior à estipulada, tirar ou não tirar os olhos da estrada por dois segundos para ajustarmos o rádio ou trocarmos um CD, atendermos ou não o telemóvel, acelerar em frente a um sinal amarelo, entre outras variadíssimas situações. E, como se pode ler num interessantíssimo artigo intitulado “The Moral Challenges of Driverless Cars”, “todas estas decisões têm, em simultâneo, componentes morais e práticas, o que explica que a possibilidade destes veículos autónomos – os quais utilizam uma combinação de sensores e de lógica pré-programada para avaliar e reagir a variadas situações – partilharem a estrada com outros veículos, peões ou ciclistas, esteja a criar tanta consternação – e confusão – entre os defensores da tecnologia e os da ética”.

Para os adeptos da tecnologia, os veículos autónomos do futuro terão a capacidade de ultrapassar, em mestria, o que a maioria dos humanos faz enquanto conduz, exactamente porque terão capacidades perceptivas mais “afinadas”, melhores tempos de reacção e porque não sofrem de distracções – como comer, escrever SMS, ter sono ou até emergências físicas, como ataques cardíacos, por exemplo.

O argumento dos 90% de acidentes causados por erro humano é também utilizado por Bryant Walker Smith, professor no Center for Internet and Society da Stanfod Law School e também ele especializado em robótica e em veículos autónomos. “Por muito perigoso que seja conduzir”, escreve, “os triliões de quilómetros percorridos anualmente nas estradas de todo o mundo demonstram que os acidentes são, mesmo assim, eventos não muito habituais. A esperança – mesmo que neste momento não passe disso mesmo, de uma esperança – é a de que a automação possa reduzir ainda mais esses acidentes sem introduzir, em simultâneo, novas fontes de erros”.

Porque a ética tem de andar de mãos dadas com a tecnologia

Os dilemas éticos aqui aflorados representam, neste momento, apenas uma ínfima ponta do gigantesco icebergue que, não só nesta questão em particular, mas no que diz respeito aos progressos acelerados que estão a trazer a inteligência artificial cada vez mais perto do presente, terão implicações em praticamente todas as áreas da nossa vida enquanto humanos.

E é por isso que, cada vez mais, se exigem respostas e soluções de controlo que sejam éticas, as quais devem ser pensadas e implementadas antes que seja tarde demais. E o sector dos veículos autónomos representa um bom exemplo do que pode ser feito, ao mesmo tempo que alerta para o muito que há ainda a fazer.

É o caso de Chris Gerdes, mas não só, um professor de Stanford responsável por um laboratório de investigação que lida com tecnologias ultra-sofisticadas, em termos de hardware e software, especificamente dedicadas aos veículos autónomos. Só que e em conjunto com o professor de filosofia Patrick Lin, director do Ethics + Emerging Sciences Group, está também a explorar os dilemas éticos que poderão vir a surgir quando os veículos autónomos forem comercializados e utilizados no mundo real. No ano passado, Gerdes e Lin organizaram um workshop que juntou engenheiros e filósofos para discutirem estas questões, sendo que o tema está a ganhar crescente importância, apesar de serem muitos os que afirmam também que os fabricantes como a Google, a Volkswagen ou a Mercedes não irão, de todo, esperar pela resolução destes dilemas.

Apesar de ainda não existirem veículos completamente autónomos, a tecnologia da condução automatizada está a ser integrada, e rapidamente, em muitos carros. E, dentro de poucos meses, são já vários os fabricantes que planeiam lançar veículos capazes de, sozinhos, conduzir, acelerar ou travar em auto-estradas e ao longo de períodos de tempo consideráveis. Adicionalmente, existem já vários modelos que têm neles “embutidos” sensores que detectam a presença de peões ou ciclistas e que avisam os condutores de potenciais “anomalias” no trânsito. E, até agora, os veículos sem condutor, utilizados em testes, por exemplo, pela Google, não sofreram acidentes de maior, apesar de ainda só conseguirem lidar com situações potencialmente perigosas de uma forma bastante simples: parando.

Uma das experiências apresentadas por Gerdes num evento desta inovadora indústria é muito similar à que deu início a este texto: a de uma criança que corre para o meio da estrada, forçando o carro sem condutor a escolher entre atropelar a criança ou guinar e chocar com uma camioneta. Mas a questão colocada por Gerdes à audiência é diferente e, por isso mesmo, coloca mais um dilema ético nada fácil de ser solucionado. Citado pela Technology Review, Gerdes questiona: “Ao olharmos para esta situação com olhos humanos, um destes ‘obstáculos’ tem muito mais valor do que o outro. Assim, qual é a responsabilidade do carro?” Ou seja, eticamente não existiriam dúvidas que a resposta devia ser salvar a criança. Mas terá o veículo a “permissão” necessária para optar por magoar os ocupantes do carro?

No mesmo evento, o professor alertou todos os presentes – desde investigadores, a engenheiros, sem esquecer os executivos da indústria – que todas estas considerações éticas terão de ser realmente levadas a sério e à medida que a tecnologia se vai desenvolvendo. E, como recordou, “não é possível comprarmos um módulo de ética e encaixarmo-lo no veículo”.

Voltando aos três investigadores que publicaram o resultado das suas experiências na revista Science há uma semana, são eles os primeiros a reconhecer que a discussão dos dilemas morais consiste num “trabalho em progresso”. E foi também por isso que lançaram, no mesmo dia em que o seu estudo foi publicado, um novo website, o qual baptizaram adequadamente de Moral Machine e que tem como objectivo ajudar a recolher mais informação sobre as preferências dos futuros utilizadores de veículos autónomos no que respeita à reacção dos mesmos face a diferentes cenários que implicam perigo e escolhas.

Já o também citado Bryant Walker Smith continua com o pé no acelerador e defende que, dado o número de acidentes fatais que envolvem o erro humano na actualidade, poderá também ser considerado pouco ético abrandar o progresso tecnológico no que a este tipo de veículos diz respeito. “A maior questão ética existente reside em quão rapidamente nos moveremos. Temos uma tecnologia com potencial para salvar muitas vidas, mas que também será imperfeita e poderá matar”, remata.

A escolha não é, realmente, fácil. E outros e mais outros dilemas se seguirão.

Não deixe de ver o vídeo: O dilema social dos veículos autónomos

Editora Executiva